Gießereien müssen sich in der Zukunft einer Vielzahl von technologischen, wirtschaftlichen und nachhaltigkeitsbezogenen Herausforderungen sowie einem zunehmenden Wettbewerbsdruck stellen. Dies wird nicht ohne die konsequente Weiterentwicklung der Prozesstechnik und -steuerung durch den Einsatz intelligenter, adaptiver Produktionssysteme möglich sein. Ziel des hier vorgestellten Projekts war es, den Energieverbrauch und dessen Optimierungspotenzial beim Schmelzen von Stählen im Mittelfrequenz-Induktionsofen zu modellieren.

VON TIM KAUFMANN, DIERK HARTMANN, KEMPTEN UND CHRISTOPH JONAS, FRIEDRICH LOHMANN-VOSS, WITTEN

Neben der Konkurrenz aus Schwellenländern, erhöhten Flexibilitätsanforderungen und dem steigenden Liefer- und Qualitätsdruck, wird der zu erwartende ökologische und ökonomische Wandel hin zu einem klimaneutralen Europa die Gießereibranche in den kommenden Jahren vor immer größere Herausforderungen in Bezug auf Ressourcen- und Energieeffizienz stellen. Zusätzlich belasten die hohen Strom- und Rohstoffkosten, welche im europäischen Vergleich in Deutschland aktuell am höchsten sind, die Gießerei-Industrie [1]. Dies rückt Nachhaltigkeit und Ressourcenschonung in den Mittelpunkt der zukünftigen Geschäftsstrategien. In der Digitalisierung der Prozesskette liegt ein hohes Potenzial, um die Fertigung widerstandsfähiger, nachhaltiger und flexibler zu gestalten.

Für die effiziente Nutzung von Produktionsdaten ist eine Datenanalyse mit Methoden des maschinellen Lernens, Deep Learning und Transfer Learning-Ansätzen sowie der Rückspiegelung der Analyseergebnisse in die Produktion unabdingbar. Als besonders zielführend gilt der Aufbau sogenannter cyber-physischer Produktionssysteme [2]. Ihr Einsatz ermöglicht sowohl die Optimierung einzelner Prozes0se und ihrer Parameter als auch gesamter Prozessketten [3]. Dieser Ansatz ist damit prädestiniert, den immer komplexeren Anforderungen nachhaltiger Prozesse gerecht zu werden. Es existieren verschiedene Ansätze zur Anwendung von KI-Methoden und Assistenz-Apps in der Gießerei-Industrie, wie zum Beispiel in [4-8] beschrieben. Ein ganzheitliches Ökosystem von Assistenzanwendungen für eine Optimierung des Gießereiproduktionssystems ist hingegen bis heute noch nicht Stand der Technik.

Im Folgenden soll exemplarisch gezeigt werden, wie mithilfe des maschinellen Lernens der Prozess des Schmelzens von Stählen (hier die Qualität X153Cr-MoV12, 1.2379, Werkzeugstahl) im Mittelfrequenz-Induktionsofen analysiert und modelliert werden kann. Ziel ist es, die Einflussfaktoren der individuellen Gattierung auf den jeweiligen Energieverbrauch numerisch zu beschreiben und so in der Zukunft eine wissensbasierte, kostenoptimierte Gattierung zu ermöglichen.

Datenbasis und Ausgangssituation

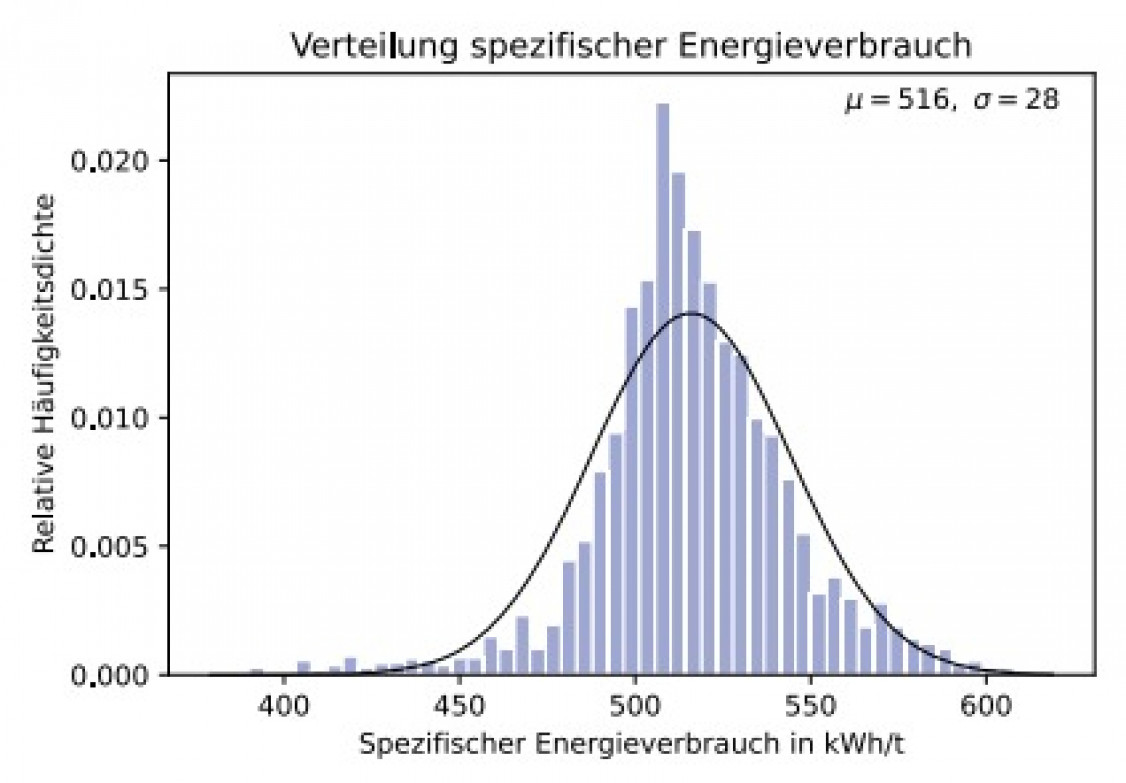

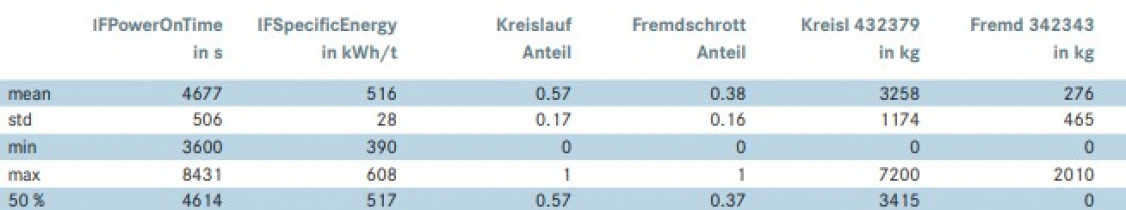

Für die Modellierung des Schmelzprozesses wurden Daten des Mittelfrequenz-Induktionsofen der Firma Lohmann zur Verfügung gestellt. Diese beinhalten Informationen über die Gattierung (Schrotttyp, Fremd- oder Kreislaufschrott, Anteil Kreislauf- oder Fremdschrott an der Gattierung, Mengen in kg etc.) und thermophysikalische Informationen des Schmelzprozesses (Schmelzdauer, Einschaltzeit des Ofens in s, spezifischer Energieverbrauch in kWh/t etc.). Bild 1 zeigt die Verteilung des spezifischen Energieverbrauches im genutzten Datensatz der 1.2379-Schmelzen. Der Mittelwert des Energieverbrauches beträgt ca. 516 kWh/t. Tabelle 1 zeigt einen Auszug aus dem verwendeten Datensatz, welcher die Daten von ca. 2400 individuellen 1.2379-Schmelzen umfasst. Die Schrotttypen sind mit werksinternen Kennzeichnungen bezeichnet, wobei die letzten Ziffern die Sorte des Schrottes angeben. Der Datensatz umfasst 60 Einflussvariablen (unterschiedliche Schrotttypen (z.B. Hackschrott), Anteil Kreislaufschrott und Fremdschrott (Zukaufschrott) an der Gattierung etc.) und den Energieverbrauch als Zielgröße.

Zur Diskretisierung der Zielgröße (spezifischer Energieverbrauch) wurden die Daten in die zwei Gruppen Energieverbrauch kleiner (gelabelt als „0“) und größer (gelabelt als „1“) des Medians (517 kWh/t) aufgeteilt und anschließend mittels Maschinellem Lernen ein Modell zur Vorhersage der jeweiligen Klasse erstellt. Hierzu wurde das „XGBoost“-Framework [9] zur Modellerstellung (überwachtes Lernen) und das „SHAP-Framework“ [10] zur Modellinterpretation genutzt.

Maschinelles Lernen

Unter Maschinellem Lernen (ML) versteht man die Programmierung von Computern zur Optimierung eines Fähigkeitskriteriums anhand von Beispieldaten oder Erfahrungswerten. ML konzentriert sich auf die Entwicklung von Computerprogrammen, welche auf Daten zugreifen und diese nutzen, um automatisch für sich selbst Muster in den Daten zu lernen. Aufgrund der zunehmenden Menge und Vielfalt der verfügbaren Daten in der Prozessindustrie und der immer günstigeren und leistungsfähigeren Hardware können zunehmend komplexere, robustere und präzisere Systeme entwickelt werden. Diese sind in der Lage eine „intelligente“ Verarbeitung der Daten durchzuführen, weshalb das Maschinelle Lernen bzw. das Thema Künstliche Intelligenz in den letzten Jahren viel Aufmerksamkeit sowohl in der Öffentlichkeit als auch in der Forschung erhalten hat. In der Praxis lassen sich die Algorithmen des Maschinellen Lernens je nach ihrem Zweck in drei Hauptkategorien einteilen:

> Beim überwachten Lernen lernt ein ML-Modell aus Beispieldaten und zugehörigen Zielantworten, welche aus numerischen Werten oder String-Etiketten wie Klassen oder Tags bestehen können. Diese werden bei neuen Beispielen bzw. Input-Daten genutzt, um eine mögliche Antwort vorherzusagen. Überwachtes Lernen wird häufig in Anwendungen eingesetzt, bei denen historische Daten wahrscheinliche zukünftige Ereignisse vorhersagen. Im Allgemeinen werden Probleme des überwachten Lernens in Klassifizierung und Regression unterteilt. Bei Regressionsproblemen versucht das Modell, Ergebnisse innerhalb einer kontinuierlichen Ausgabe auf der Grundlage der kontinuierlichen Funktionen (Eingangsparameter, Merkmale oder auch Features genannt) vorherzusagen. Bei der Klassifizierung hingegen wird die Ausgabe lediglich als diskreter Wert vorhergesagt.

> Unüberwachtwes Lernen: Im Gegensatz zum überwachten Lernen, das anhand von markierten Beispielen trainiert wird, wird hier ein Lernmodell erstellt, indem Strukturen in den Eingabedaten ohne zugehörige Antwort abgeleitet werden, sodass der Algorithmus die Datenmuster selbständig bestimmen kann. Ein typisches Beispiel ist ein Empfehlungssystem, das Segmente von Kunden mit ähnlichen Merkmalen ermitteln kann. Solche Systeme finden beispielsweise zur Kategorisierung in Marketingkampagnen Anwendung. Populäre Techniken aus diesem Bereich sind z.B. das Clustering und die Dimensionsreduktion.

> Der Dritte Ansatz beschreibt das Verstärkungslernen. Hier geht es um die Frage, wie das Modell mit der Umwelt interagiert und in einer gegebenen Situation geeignete Handlungen auswählt, um die „Belohnung“ zu maximieren. Diese Art des Lernens wird häufig in der Robotik, bei digitalen Spielen und in der Navigation eingesetzt [11-13].

ML – Algorithmen

Zu jedem der oben genannten Bereiche gibt es eine Vielzahl an Methoden und Algorithmen, die alle einen anderen Ansatz des Lernens verfolgen. Ein künstliches neuronales Netz lernt gänzlich anders als ein auf Entscheidungsbäumen basierendes System, wie z.B. der Random Forest-Algorithmus. Die Auswahl des richtigen Algorithmus ist nicht einfach und hängt von den spezifischen Randbedingungen ab. Hierbei sind beispielsweise die Größe und Art der zu verwendenden Daten und die anvisierten Ergebnisse klassische Auswahlkriterien.

XGBoost.

Für die Modellerstellung in diesem Beitrag wurde der sogenannte XGBoost–Algorithmus genutzt. XGBoost (Extreme Gradient Boosting) ist eine skalierbare, verteilte GBDT-Bibliothek (Gradient-Boosted-Decision-Tree) für Maschinelles Lernen. Ein GBDT ist ein Ensemble-Lernalgorithmus für Entscheidungsbäume (ähnlich dem Random Forest) für Klassifizierung und Regression. Ensemble-Lernalgorithmen kombinieren mehrere maschinelle Lernalgorithmen, um ein besseres Modell im Vergleich zu ihren kompositionellen singulären Algorithmen zu erhalten. Entscheidungsbäume erstellen ein Modell, das eine Zielgröße vorhersagt, indem sie einen Baum von Wenn-dann-Falsch-Fragen mit wahr-/falsch-Merkmalen auswerten. Hieran wird die Mindestanzahl von Fragen geschätzt, die mit einer ausreichenden Wahrscheinlichkeit zu einer richtigen Prognose führen [14]. Entscheidungsbäume können zur Klassifizierung verwendet werden, um eine Kategorie vorherzusagen, oder zur Regression, um einen kontinuierlichen numerischen Wert vorherzusagen. Wenn es um kleine bis mittelgroße strukturierte/ tabellarische Daten geht, gelten Entscheidungsbaum-basierte Algorithmen wie der XGBoost derzeit als die Besten ihrer Klasse.

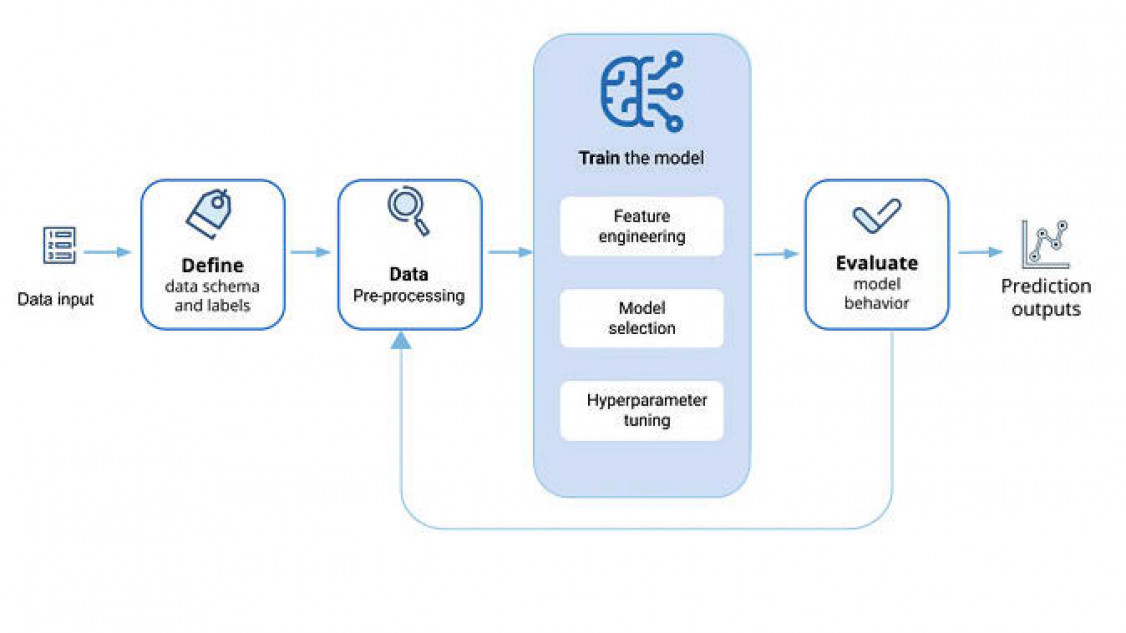

ML – Workflow

Der Workflow für Projekte, die mit Maschinellem Lernen gelöst werden sollen, stellt sich in der Regel immer gleich dar:

Datenerfassung.

Um ein Projekt zum Maschinellen Lernen zu beginnen, müssen zunächst Daten aus relevanten Quellen gesammelt werden. Dabei handelt es sich um das Abrufen relevanter Fertigungsinformationen, die Umwandlung der Daten in die erforderliche Form und das Laden in das vorgesehene Modell. Die in der Gießerei gesammelten Daten stammen aus verschiedenen Quellen, wie ERP-Datenbanken, IoT-Geräten, Ofensteuerungen usw.

Datenvorverarbeitung.

Sobald die Daten gesammelt sind, müssen sie vorverarbeitet werden. Dies umfasst das Bereinigen, Überprüfen und Formatieren der Daten zu einem geeigneten Datensatz und ist der wichtigste Schritt, der dazu beiträgt, Modelle für Maschinelles Lernen genauer in ihrer Prognose zu machen. Die allererste Maßnahme der Vorverarbeitung besteht darin, fehlende Daten zu identifizieren. Sie sind in den meisten realen Datensätzen üblich und solche Werte müssen zunächst bearbeitet werden, um die verfügbaren Daten optimal nutzen zu können. Eine grundlegende Strategie zur Nutzung unvollständiger Datensätze besteht darin, ganze Zeilen oder Spalten mit fehlenden Werten zu verwerfen. Dies hat jedoch den Nachteil, dass informative Daten verloren gehen, die für das Modelltraining wertvoll sein könnten. Eine Alternative dazu ist die Imputation. Diese strebt an, fehlende Werte aus dem bekannten Teil der Daten abzuleiten. Im Allgemeinen profitieren Lernalgorithmen von einer Standardisierung des Datensatzes, denn verschiedene Spalten innerhalb eines Datensatzes können in unterschiedlichen Wertebereichen vorhanden sein. So kann es beispielsweise eine Spalte mit der Einheit Prozent und eine andere mit der Einheit der Temperatur geben. Diese Spalten haben sehr unterschiedliche Wertebereiche, was es für viele Modelle des Maschinellen Lernens schwierig macht, einen optimalen Berechnungszustand zu erreichen. Es gibt einige Techniken, dieses Problem zu lösen: Standardisierung, Entfernung des Mittelwerts und Varianzskalierung (Skalierung von Merkmalen auf einen Bereich, oft zwischen Null und Eins, oder so, dass der maximale absolute Wert jedes Merkmals auf eine Einheitsgröße skaliert wird).

In vielen Fällen haben die Daten ein Format, welches von Algorithmen nicht verarbeitet werden kann. Eine Spalte mit String-Werten oder Text ist beispielsweise für ein Modell, das nur numerische Werte als Eingabe akzeptiert, bedeutungslos. Daher müssen kategorische Merkmale in ganzzahlige Codes umgewandelt werden, damit das Modell sie interpretieren kann. Diese Methode wird als kategoriale Kodierung bezeichnet. Zu den gängigen Ansätzen gehört die ordinale Kodierung, die Werte von 1 bis n ordinal einbettet, wobei n die Anzahl der Stichproben in der Spalte ist. Zusätzlich zu der Datenaufbereitung ist das sogenannte „feature engineering“ beim Erstellen von ML-Modellen wichtig für die Modellperformance. Hierunter versteht man das Erstellen von neuen Merkmalen („Features“) aus den Rohmerkmalen. So können zum Beispiel Tag, Monat und Jahr aus einer Datum-Zeit-Spalte extrahiert werden. Dadurch erhält das Modell eine neue Perspektive und kann nun eine ganz neue Beziehung zwischen der Zeit und der Zielvariablen erkennen.

In ähnlicher Weise ist die Diskretisierung ein Prozess, bei dem kontinuierliche Merkmale in diskrete Werte aufgeteilt werden. Bestimmte Datensätze mit kontinuierlichen Merkmalen können von der Diskretisierung profitieren, da sie den Datensatz mit kontinuierlichen Attributen in einen solchen mit nur nominalen Attributen umwandeln kann. Es kann zudem sinnvoll sein, die Komplexität des Modells durch Berücksichtigung nichtlinearer Merkmale der Eingabedaten zu erhöhen. Eine gängige Methode ist die Verwendung polynomialer Merkmale, z. B. können die Merkmale von X von (X1, X2) in (1, X1, X2, X1*X2, X1 2, X2 2) transformiert werden. Ein Anwendungsbeispiel im genutzten Datensatz ist das Summieren von bestimmten Schrottkategorien des Originaldatensatzes zu einer Überkategorie, z.B. die Summe aller „Fremdschrotte_Hackschrotte“ einer Gattierung zu einer neuen Spalte im Datensatz zu ergänzen.

Training des Modells.

Bevor das Modell trainiert wird, müssen die Daten in Trainings- und Testdaten aufgeteilt werden. Das Trainingsset wird verwendet, um den Algorithmus zunächst zu trainieren und ihm „beizubringen“, wie er Informationen verarbeiten soll. Der Testdatensatz wird verwendet, um die Genauigkeit und Leistung des Modells im Anschluss an das Training zu überprüfen. Sobald der Datensatz für das Training bereit ist, besteht der nächste Schritt darin, den Algorithmus mit dem Trainingssatz anzulernen, damit er geeignete Parameter und Merkmale für den Lernprozess erlernen kann. Um die Leistung des Modells für das Klassifikationsproblem zu beurteilen, werden die folgenden Bewertungsmetriken [9] genutzt, wobei im Kontext dieses Artikels gilt:

> True positive (TP): Der spezifische Energieverbrauch liegt in Klasse 0 (< 517 kWh/t) und das Modell hat dies richtig prognostiziert.

> True negative (TN): Der spezifische Energieverbrauch liegt in Klasse 1 (> 517 kWh/t) und das Modell hat dies richtig prognostiziert.

> False negative (FN): Der spezifische Energieverbrauch liegt in Klasse 1, aber das Modell hat ihn fälschlicherweise als Klasse 0 prognostiziert.

> False positive (FP): Der spezifische Energieverbrauch liegt in Klasse 0, aber das Modell hat ihn fälschlicherweise als Klasse 1 prognostiziert.

Accuracy.

Die Genauigkeit wird als statistisches Maß dafür verwendet, wie korrekt ein binäres Klassifikationsmodell einen Zustand identifiziert oder ausschließt. Das heißt, die Genauigkeit ist der Anteil der korrekten Vorhersagen (sowohl wahrpositive als auch wahr-negative) an der Gesamtzahl der untersuchten Fälle. Es ist das Verhältnis zwischen der Anzahl der richtigen Vorhersagen und der Gesamtzahl der Stichproben:

Accuracy = (TP+TN)/(TP+TN+FP+FN)

Precision.

Die Präzision ist der Prozentsatz der Vorhersagen, die richtig (positiv) waren. Je höher sie ist, desto weniger falsch-positive Vorhersagen werden getroffen. Wenn das Modell beispielsweise prognostizieren soll, ob eine Gattierung einen geringen (Klasse 0) oder hohen (Klasse 1) Energieverbrauch beim Schmelzen induzieren wird, bedeutet ein Präzisionswert von 0,2, dass das Modell 20 % aller Klassenzuordnungen in den Testdaten korrekt identifiziert.#

Precision = TP/(TP+FP)

Recall.

Der Prozentsatz aller Elemente der Grundwahrheit, die vom Modell erfolgreich vorhergesagt wurden. Je höher der Recall-Wert ist, desto weniger falsch-negative Vorhersagen wurden getroffen.

Recall = TP/(TP+FN)

F1-Score.

Der F1-Score ist das harmonische Mittel aus Precision und Recall oder eine Art gewichteter Durchschnitt der beiden Metriken.

F1-Score = 2*(Precision*Recall)/(Precision+Recall)

Grundsätzlich „bestraft“ der F1-Score Modelle, die zu stark auf Präzision oder Recall ausgerichtet sind, und ist somit eine gute Metrik zur Messung der Gesamtleistung eines Modells.

Konfusionsmatrix.

Eine Konfusionsmatrix fasst die Klassifizierungsleistung eines Klassifikationsmodells in Bezug auf die Testdaten zusammen. Es handelt sich um eine zweidimensionale Matrix, die in einer Dimension durch die wahre Klasse eines Objekts und in der anderen durch die Klasse, die das Modell zuordnet, indiziert ist. Die Matrix ist eine Zusammenfassung der Vorhersageergebnisse für ein Klassifizierungsproblem. Die Anzahl der richtigen und falschen Vorhersagen wird mit Zählwerten zusammengefasst und nach den einzelnen Klassen aufgeschlüsselt.

Modellbewertung.

Nachdem ein akzeptabler Satz von Hyperparametern (Parameter, die zur Steuerung des Trainingsalgorithmus verwendet werden und dessen Werte im Gegensatz zu anderen Parametern vor dem eigentlichen Training des Modells festgelegt werden müssen, wie z.B. maximale Tiefe eines Baumes im ganzen Entscheidungsbaum) gefunden und die Modellleistung optimiert wurde, kann das Modell schließlich getestet werden. Dabei wird der Testdatensatz verwendet, um zu überprüfen, wie genau die Modelle das gewünschte Ergebnis prognostizieren können. Auf der Grundlage des erhaltenen Feedbacks kann man zum Training des Modells zurückkehren, um die Leistung zu verbessern, die Ausgabeeinstellungen anzupassen oder das Modell nach Bedarf einzusetzen. Bild 2 zeigt den typischen Workflow eines ML-Projektes auf.

SHAP-Werte

Die zunehmende Nutzung von ML bzw. Künstlicher Intelligenz erhöht den Bedarf, die Prognosen der Modelle nachvollziehen zu können. Die Anwender von ML müssen in der Lage sein, Entscheidungen vollständig nachzuvollziehen, um ein ausreichendes Vertrauen in deren Ergebnisse zu haben. Im Prinzip müssen ML-Modelle wie erwartet funktionieren und transparente Erklärungen liefern. Eine aktuell sehr weitverbreitete und bewiesenermaßen leistungsvolle Methode, ML-Modelle interpretierbar zu machen, ist das „SHAP-Framework“ [16]. SHAP („SHapley-Additive-exPlanations“) ist ein spieltheoretischer Ansatz zur Erklärung des Outputs eines beliebigen maschinellen Lernmodells. Das Wesen des Shapley-Wertes besteht darin, die Beiträge zum Endergebnis (hier der Energieverbrauch) von jedem Spieler (Einflussvariablen wie z.B. gattierter Schrott) separat in der Koalition zu messen, wobei die Summe der Beiträge gleich dem Endergebnis ist.

In diesem Beitrag wird nicht auf die mathematische Herleitung zur Berechnung von SHAP-Werten eingegangen. Interessierte Leser können umfangreiche Erläuterungen den Quellen [10, 17-19] entnehmen. Es gibt weitere Techniken zur Erklärung von Modellen, wie z. B. Permutationsbedeutung oder partielle Abhängigkeitsdiagramme. Allerdings überwiegen aktuell die Vorteile des SHAP-Frameworks gegenüber anderen Techniken in folgenden Punkten:

> Globale Interpretierbarkeit: SHAP-Werte zeigen nicht nur die Wichtigkeit eines Merkmals, sondern auch, ob das Merkmal einen positiven oder negativen Einfluss auf die Vorhersagen hat.

> Lokale Interpretierbarkeit: SHAP-Werte können für jede einzelne Vorhersage berechnet werden und so dabei helfen zu verstehen, wie die Merkmale zu dieser einzelnen Vorhersage beitragen. Andere Verfahren zeigen nur aggregierte Ergebnisse für den gesamten Datensatz.

SHAP-Werte können zur Erklärung einer Vielzahl von Modellen verwendet werden, darunter lineare Modelle (z. B. lineare Regression), baumbasierte Modelle (z. B. XGBoost) und neuronale Netze, während andere Verfahren nur zur Erklärung begrenzter Modelltypen verwendet werden können. Im Rahmen dieses Beitrags wird daher nur auf SHAP zurückgegriffen.

Ergebnisse

Das physikalische und technische Optimum als Referenz

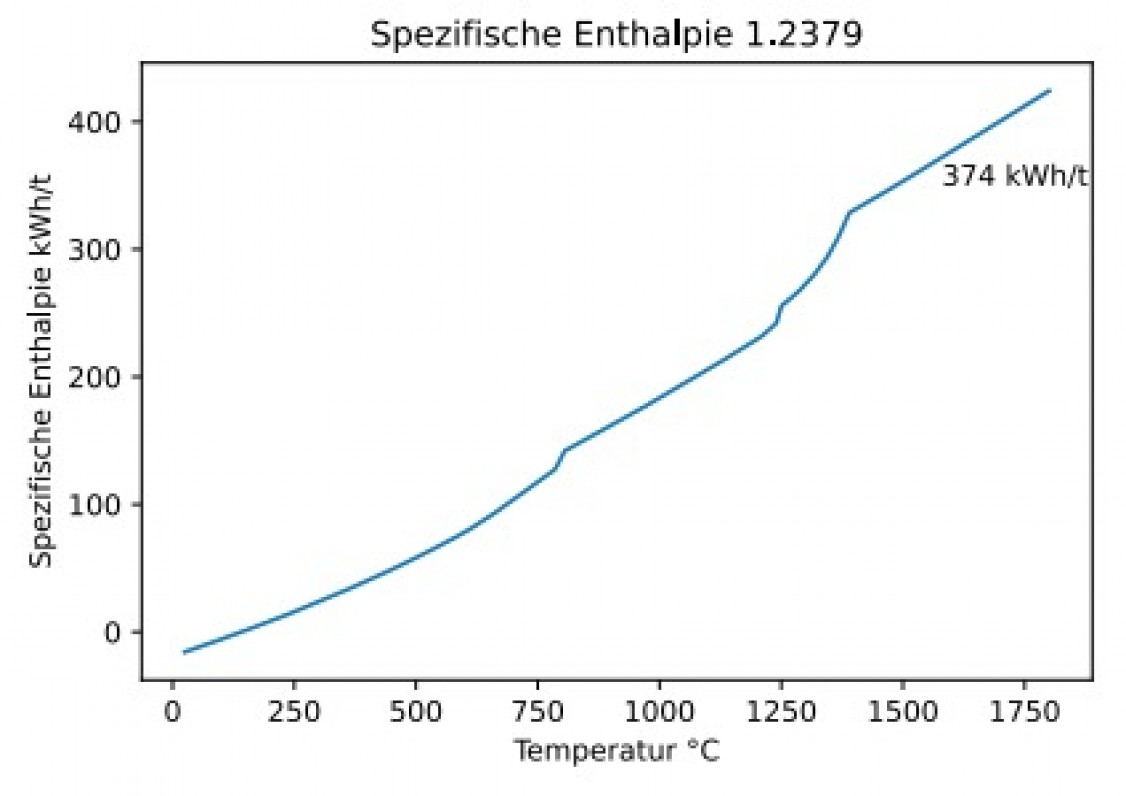

Um zu beurteilen, inwiefern ein mögliches Optimierungspotenzial bzgl. des Energieverbrauchs beim Schmelzen vorhanden ist, wird das „physikalische Optimum“ (PhO) als Referenz genutzt. Unter dem PhO versteht man einen unter physikalischen, biologischen und chemischen Randbedingungen theoretisch optimalen Referenzprozess [20]. Das PhO beim Schmelzen ist die theoretisch benötigte Energie um eine Legierung von Raumtemperatur (hier 25 °C) auf den gewünschten Schmelzbereich (für Stahl 1.2379 ca. 1600 °C) zu erhitzen bzw. aufzuschmelzen. Dieser Wert ist nur von theoretischer Natur, der in der Realität nicht erreicht werden kann, denn ein idealisierter, physikalisch optimaler Schmelzofen müsste eine komplett adiabate Tiegelwand, eine verlustfreie Stromversorgung und eine supraleitende Spule aufweisen, was technisch nicht realisierbar ist [21]. Nichtsdestotrotz lässt sich mit dem PhO das vorhandene Optimierungspotenzial grob abschätzen. Will man reinen Stahlschrott der Qualität 1.2379 aufschmelzen, müssen theoretisch minimal ca. 374 kWh/t an Schmelzenergie aufgebracht werden (Bild 3, Annahme Schmelzofen-Wirkungsgrad 100 %). In der Regel wird eine Stahllegierung aber nicht aus reinen Qualitäten erschmolzen, sondern aus unterschiedlichen Rohstoffen mit verschiedenen Reinheiten und dementsprechend unterschiedlichen Enthalpien. Weiterhin werden hierbei Wärme- oder Materialverluste (z.B. Abbrand) nicht berücksichtigt.

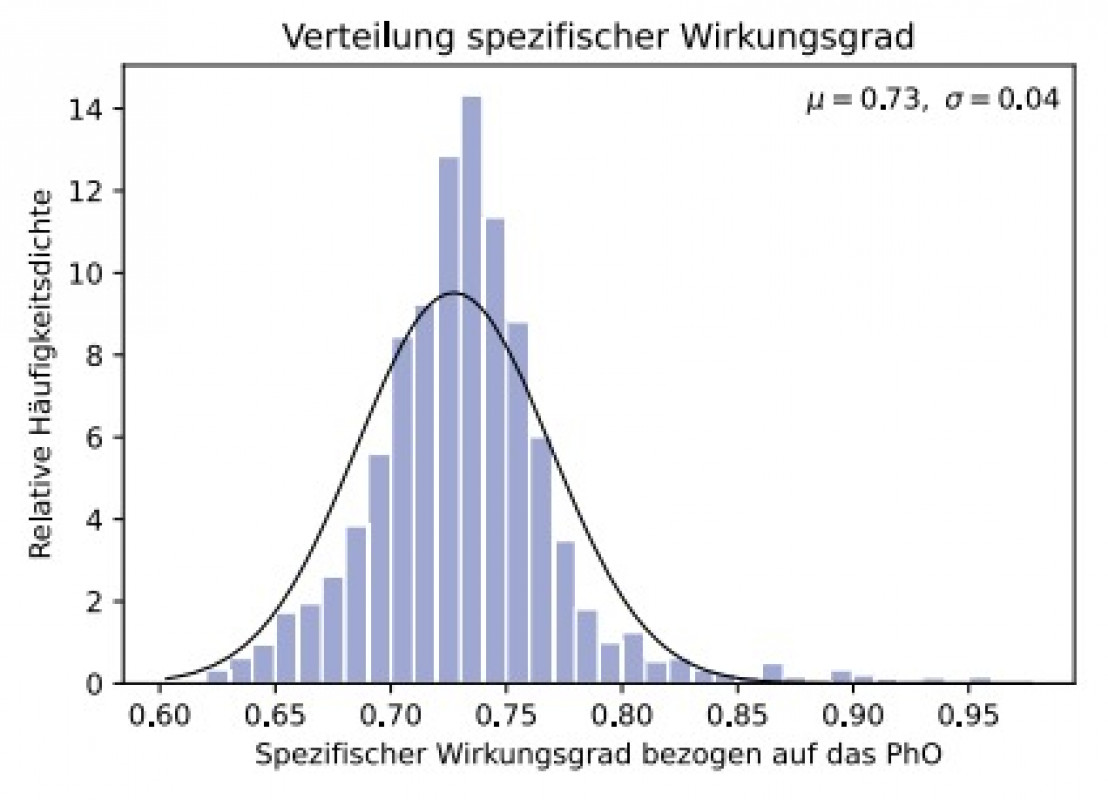

Im Anschluss an den Schmelzvorgang erfolgt, sofern die Zielzusammensetzung nicht erreicht wurde, die Zugabe von Legierungselementen, was die Enthalpiebilanzierung weiter erschwert. Trotzdem lässt sich hiermit grob abschätzen, wie weit der reale Schmelzprozess vom PhO abweicht. Aus den Daten der gemessenen Energieverbräuche (517 kWh/t, bezogen auf den Median) und dem physikalischen Optimum (374 kWh/t) errechnet sich die Abweichung zu ca. 38 %, d.h. es besteht ein theoretisches Einsparpotenzial im Median von ca. 142 kWh/t (0.38*PhO). Einige hundert Schmelzen in dem Datensatz weisen allerdings einen deutlich höheren Energieverbrauch bis zu 605 kWh/t auf, d.h. das Optimierungspotenzial liegt voraussichtlich etwa im Bereich von 142 bis 232 kWh/t. Typischerweise geht man beim induktiven Schmelzen von einem Wirkungsgrad von ca. 75 % aus [22]. Der mittlere spezifische Wirkungsgrad bezogen auf das PhO (374/517 = 73 %) liegt im 1.2379-Datensatz hier sehr nah an diesem Wert (Bild 4), d.h. der Prozess läuft bereits vergleichsweise energieeffizient.

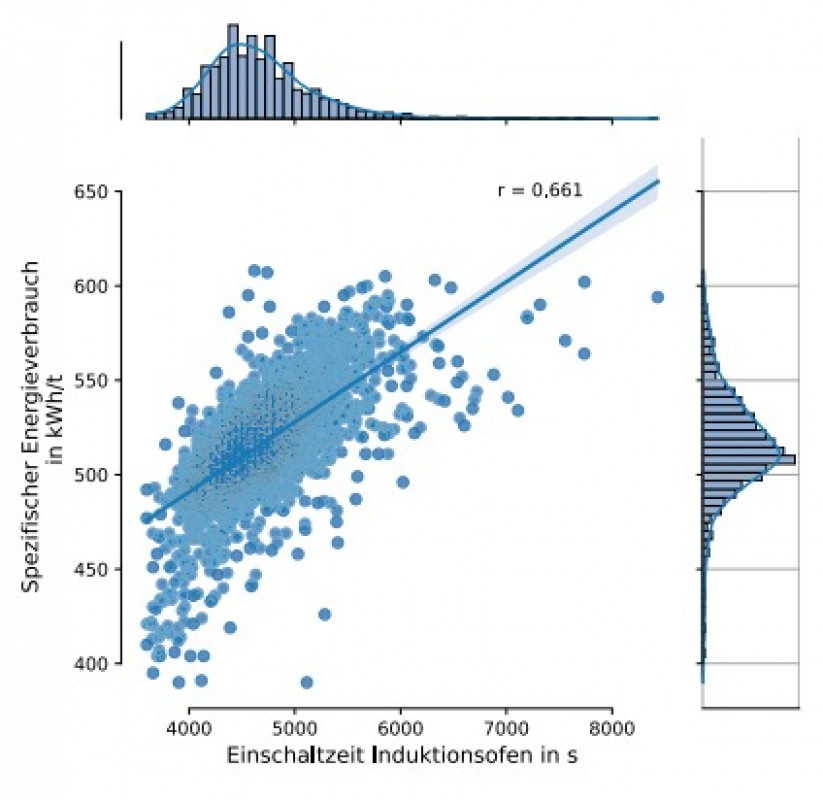

Ein gewisser Anteil des genannten Einsparpotenzials wird in Zukunft wahrscheinlich durch prozesstechnische Lösungen (verbesserte thermische Isolation des Ofens, Erhöhung des Wirkungsgrades, allgemeine technische Optimierungen etc.) gelöst werden. Darüber hinaus ist auch die Fahrweise des Ofens von großer Bedeutung, da z.B. nicht optimale Gattierungs- bzw. Prozesszeiten einen erhöhten Wärmeverlust induzieren und den Energieverbrauch steigern. Die Analyse des Datensatzes zeigt, dass die Einschaltzeit des Ofens („IFPowerOnTime“) den größten Einfluss auf den Energieverbrauch hat (Pearson Korrelation 0,661, Bild 5).

Dieser scheinbar triviale Zusammenhang deutet dennoch auf die Komplexität des Prozesses hin. Selbst bei gleicher Einschaltzeit, z.B. 5000 s, schwankt der Energieverbrauch bei ca. 450 bis 600 kWh/t. Die Datenanalyse zeigt, dass die eingesetzten Schrotte unterschiedliche Aufschmelzverhalten aufweisen, wodurch der benötigte Energieverbrauch beeinflusst wird. Auch der Anteil an Kreislauf- oder Fremdschrott, sowie verschiedene Fremdschrotte in der Gattierung haben einen Einfluss auf den spezifischen Energieverbrauch. Mithilfe der Information, welche Schrotte in welcher Reihenfolge und mit welchen Mengen gattiert wurden, kann indirekt die zu erwartende benötigte Einschaltzeit berücksichtigt werden. Im Wesentlichen bedeutet dies, dass die Prozessdaten die „Fahrweise“ des Ofens widerspiegeln.

Modellergebnis

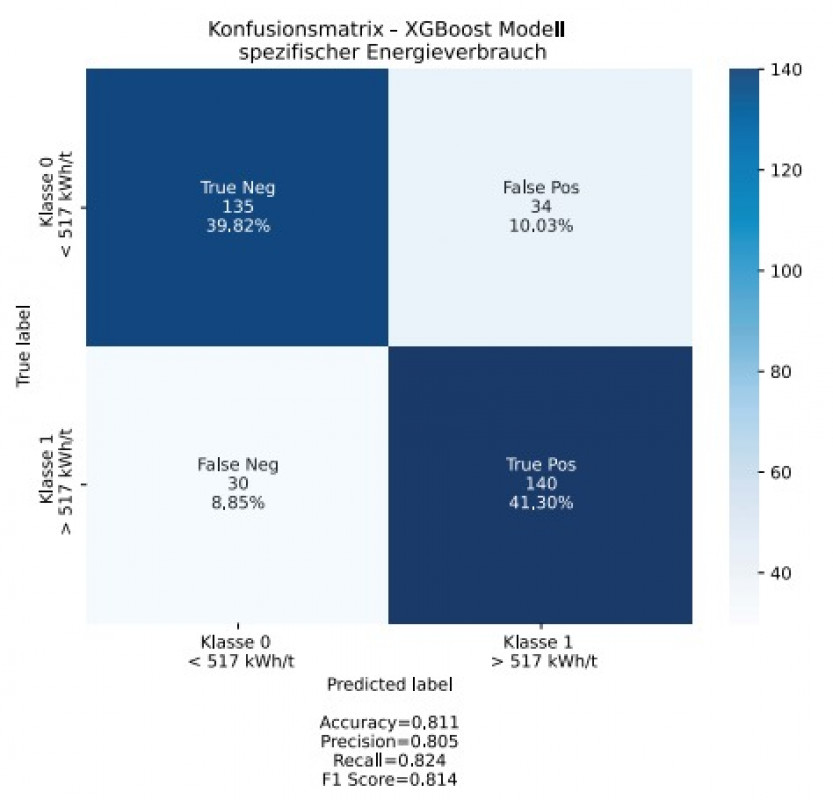

Das ML-Modell wurde mit dem beschriebenen 1.2379-Datensatz angelernt und bewertet. Mit einer Genauigkeit von ca. 81 % (Bild 6, Konfusionsmatrix, Accuracy 0,811) kann das Modell anhand der Input-Daten (Informationen über die Schrotte/Gattierung) den zu erwartenden spezifischen Energieverbrauch im Testdatensatz (Stichprobe 334 Schmelzen) prognostizieren.

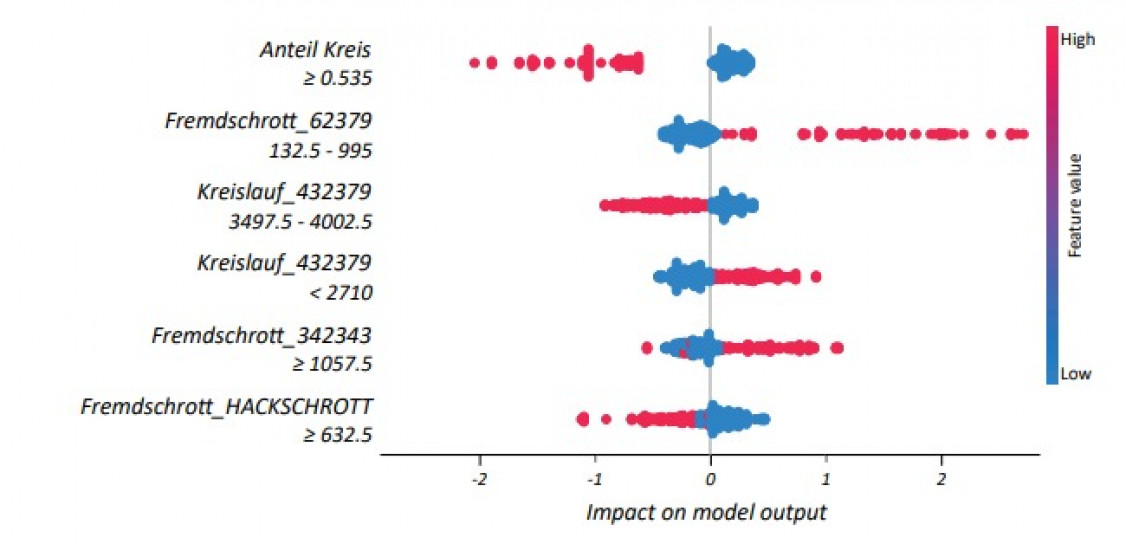

Um einen Überblick darüber zu erhalten, welche Merkmale für das Modell am wichtigsten sind, und so letztendlich auch Informationen über den Schmelzprozess bzw. die Gattierung zu erhalten, können die SHAP-Werte jedes Merkmals für die jeweiligen Schmelzvorgänge dargestellt werden. Bild 7 zeigt einen Auszug (Top 6 der 60 Inputvariablen) der Merkmale, aufgelistet nach der Summe der SHAP-Werte über alle Stichproben, sowie die Verteilung der Auswirkungen jedes Merkmals. Hierbei gibt die Reihenfolge (von oben nach unten) die absolute Einflusswichtigkeit wieder. Werte links der Nullachse implizieren einen negativen Einfluss auf die Zielgröße (Klasse 0, geringer Energieverbrauch < 517 kWh/t), d.h. alle Werte links der Nullachse implizieren einen geringen Energieverbrauch. Die Farbe im Diagramm stellt den Wert des jeweiligen Einflussmerkmals dar (rot hoch, blau niedrig).

Das Modell hat den Anteil an Kreislaufschrott in der Gattierung als wichtigste Einflussgröße detektiert (Auflistung an erster Stelle), wobei hohe Werte (rot) des Anteils die Prognose eher Richtung des geringeren Energieverbrauches (Klasse 0) verschieben. Der erhöhte Einsatz von „Fremdschrott_Hackschrott“ (> 632,5 kg) führt ebenfalls zu einem positiven Energieverbrauch, wobei für den „Fremdschrott_62379“ eher geringere Mengen in der Gattierung förderlich für einen geringeren Energieverbrauch sind. Im Kontext der Produktion erscheinen diese Ergebnisse schlüssig, da z.B. ein hoher Anteil an Kreislaufschrotten in der Gattierung dazu führt, dass weniger nachlegiert werden muss. Dies verkürzt indirekt auch die Einschaltzeit des Ofens, wodurch der Energieverbrauch verringert wird.

Das Modell hat den Anteil an Kreislaufschrott in der Gattierung als wichtigste Einflussgröße detektiert (Auflistung an erster Stelle), wobei hohe Werte (rot) des Anteils die Prognose eher Richtung des geringeren Energieverbrauches (Klasse 0) verschieben. Der erhöhte Einsatz von „Fremdschrott_Hackschrott“ (> 632,5 kg) führt ebenfalls zu einem positiven Energieverbrauch, wobei für den „Fremdschrott_62379“ eher geringere Mengen in der Gattierung förderlich für einen geringeren Energieverbrauch sind. Im Kontext der Produktion erscheinen diese Ergebnisse schlüssig, da z.B. ein hoher Anteil an Kreislaufschrotten in der Gattierung dazu führt, dass weniger nachlegiert werden muss. Dies verkürzt indirekt auch die Einschaltzeit des Ofens, wodurch der Energieverbrauch verringert wird.

Fazit

In diesem Beitrag wurde aufgezeigt, wie mithilfe von Maschinellem Lernen und einer fundierten Prozessdatenbasis der Schmelz- bzw. Gattierungsprozess im Induktionsofen hinsichtlich des Energieverbrauchs modelliert werden kann. Das Modell kann mit einer Genauigkeit von ca. 81 % anhand der Gattierung und der Fahrweise des Ofens den Energieverbrauch prognostizieren. Der Vergleich mit dem physikalischen Optimum zeigt, dass es immer noch ein Optimierungspotenzial von bis zu ca. 142 kWh/t gibt. Die Gründe hierfür sind vielfältig, liegen jedoch zum Teil an der Gattierung, denn der Einsatz von verschiedenen Schrotten, in unterschiedlichen Mengen, Qualitäten und verschiedenen Reihenfolgen gattiert, induziert hohe oder niedrige Wärmeverluste und Schmelzverhalten, was sich in unterschiedlichen Energieverbräuchen beim Schmelzen widerspiegelt. Vom Modell wird ein erhöhter Anteil an Kreislaufmaterial in der Gattierung mit einem optimierten Energieverbrauch assoziiert, was wahrscheinlich auf verkürzte Prozessdauern, durch verringertes Nachlegieren und der Vermeidung von Wärmeverlusten zurückzuführen ist. Weiteren Einfluss haben unterschiedliche Qualitäten an Fremd- bzw. Kreislaufschrotten.

Die Idee hinter diesem Prognosemodell ist, dieses in Zukunft in die im „OptiRoDig“- Projekt entwickelte Cloud-Plattform zu integrieren. Hierdurch soll versucht werden, bereits bei der Zusammenstellung bzw. beim Kauf des Schrottes eine nicht nur anhand des eigentlichen Einkaufspreises optimierte Gattierung zu erhalten, sondern auch bereits den Bezug zur Ressourcen- und Energieeffizienz herzustellen, d.h. im Wesentlichen eine Optimierung der Gattierung zu erreichen. Grundlage für derartige Modelle sind fundierte Informationen über die eingesetzten Schrotte und die Fahrweise des Ofens, d.h. solche Modelle werden in der Zukunft durch eine verbesserte Datenlage über verfügbare Schrotte und deren Eigenschaften (z.B. Stückigkeit, Schüttdichte, genaue chemische Zusammensetzung etc.) weiter optimiert werden können. Letztlich sind die Gießereien abhängig von der Verfügbarkeit einsatzfähiger Schrotte, nichtsdestotrotz lassen sich mit derartigen, datengetriebenen Prozessmodellen Einblicke in den eigenen (Schmelz-)Prozess gewinnen.

www.hs-kempten.de/forschung

www.lohmann-stahl.de

Die vorgestellten Arbeiten stammen aus dem Projekt „Optimierung der Rohstoffproduktivität in der Gießerei- und Stahlindustrie aus Produkten der Recyclingwirtschaft durch Nutzung moderner mathematischer Verfahren, Vernetzung und Digitalisierung“ (OptiRoDig). Das vom Bundesministerium für Bildung und Forschung (BMBF) geförderte Vorhaben wurde im Rahmen des Förderaufrufs „Ressourceneffiziente Kreislaufwirtschaft – Innovative Produktkreisläufe (ReziProk)“ ins Leben gerufen.

Weitere Informationen:

Hochschule für angewandte Wissenschaften Kempten

Labor für Werkstofftechnik und Betriebsfestigkeit

Prof. Dr.-Ing. Dierk Hartmann

Bahnhofstrasse 61

87435 Kempten

Tel.: +49-831-2523-195

E-Mail: dierk.hartmann@hs-kempten.de

Literatur

[1] Strompreise für Gewerbe- und Industriekunden in Deutschland in den Jahren 2011 bis 2021, https://de.statista.com/statistik/daten/studie/154902/umfrage/strompreise-fuer-industrie-und-gewerbe-seit-2006/, aufgerufen 2022.

[2] Procedia Cirp 54 (2016), pp. 7–12.

[3] Lee, J.; Noh, S.D.; Kim, H.J.; Kang, Y.S. Implementation of cyber-physical production systems for quality prediction and operation control in metal casting. Sensors 2018, 18, 1428.

[4] Ferguson, M.; Ak, R.; Lee, Y.T.T.; Law, K.H. Automatic localization of casting defects with convolutional neural networks. IEEE international conference on big data (big data). IEEE, 2017, pp. 1726–1735.

[5] Engineering Applications of Artificial Intelligence 21 (2008), pp. 1001–1012.

[6] Proceedings of the Institution of Mechanical Engineers, Part B: Journal of Engineering Manufacture 225 (2011), [Nr. 12], pp. 2276–2286.

[7] Applied Sciences 10 (2020), [Nr. 09], p. 6048.

[8] Arabian Journal for Science and Engineering 29 (2004), [Nr. 04], pp. 65–84.

[9] Scalable and Flexible Gradient Boosting, https://github.com/dmlc/xgboost, aufgerufen 2022.

[10] A game theoretic approach to explain the output of any machine learning model.https://github.com/slundberg/shap, aufgerufen 2022.

[11] The Knowledge Engineering Review 20 (2005), [Nr. 12], pp. 432–433.

[12] Mueller, J.P.; Massaron, L. Machine learning for dummies; John Wiley & Sons, 2021.

[13] Bishop, C.M. Pattern recognition. Machine learning 2006, 128, pp. 89–93.

[14] Chen, Tianqi, and Carlos Guestrin. „Xgboost: Reliable large-scale tree boosting system.“ Proceedings of the 22nd SIGKDD Conference on Knowledge Discoveryand Data Mining, San Francisco, CA, USA. 2015.

[15] Metals 12 (2021), [Nr.12], p. 1. https://doi.org/10.3390/met12010001

[16] Lundberg, S.; Lee, S.I. A unified approach to interpreting model predictions. arXiv preprint arXiv:1705.07874 2017.

[17] Ribeiro, M.T.; Singh, S.; Guestrin, C. „Why should i trust you?“ Explaining the predictions of any classifier. Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining, 2016, pp. 1135–1144.

[18] Shapley, L.S. A value for n-person games. Contributions to the Theory of Games 2 (1953, pp. 307–317.

[19] Journal of computer-aided molecular design 34 (2020), [Nr. 10], pp. 1013–1026.

[20] Volta, D.: Das Physikalische Optimum als Basis von Systematiken zur Steigerung der Energie- und Stoffeffizienz von Produktionsprozessen. Dissertation, TU Clausthal, Clausthal, 2014.

[21] Giesserei 107 (2020), [Nr. 7-8], S. 40-46.

[22] Giesserei 95 (2008), [Nr. 06]. S. 24-31.

Schlagworte

BetriebsfestigkeitCastingDesignDigitalisierungEisenEnergieeffizienzFertigungForschungMarketingMesseModellierungNachhaltigkeitProduktionRecyclingRobotikSchmelzenStahlStahlindustrieWerkstofftechnik